« Les bibliothèques, vous le savez, c’est ma passion » pourrais-je paraphraser Omar Sharif vantant le Pari mutuel urbain. Cependant j’ai aussi un autre dada : l’histoire des sciences, en particulier celle des sciences naturelles. Quoi!? vous dites-vous, il ne va pas nous parler d’Aristote, Linné, Lamarck, Cuvier, Owen, Darwin, Monod (Jacques et Théodore), Lorenz, Fabre, Rostand (Jean, pas Edmond), ou Gould (Stephen Jay, pas Barbara) dans un blog consacré aux bibliothèques?? Certes non. Quoique j’évoquerai peut-être un jour Voltaire ou Diderot.

Dans les billets précédents (et dans bien d’autres à venir 😉 ), je parle d’Internet, de ressources en ligne, mais jamais de NTIC. A cela une raison simple, cette expressions est surannée. Je dirais même qu’à l’époque où « les Nouvelles Technologies de l’Information et de la Communication » étaient à la mode (à la fin du siècle dernier, avant la bulle Internet), l’expression était déjà impropre!

Que sont ces « nouvelles » technologies? Des ordinateurs en réseau, Internet, le web, le mail… Leur invention est-elle si récente? J’ai manipulé ma première souris en 1989 (celle d’un Atari) il y a 24 ans déjà! J’étais au lycée quand j’ai vu mon premier PC, à la fac quand j’ai navigué pour la première fois (sur Netscape, avec des ordinateurs sous UNIX). Je suis de la génération Casimir, ceux qui ont le même âge se reconnaîtront, donc absolument pas un digital native. Ma génération est X, pas Y. Et pourtant l’informatique est née bien avant moi.

Sans remonter jusqu’aux ancêtres des ancêtres : Pascal et Leibniz (XVIIe), Babbage et Ada Lovelace, Jacquard et son métier (XIXe), nous allons voir que les nouvelles technologies dont nous nous gargarisions il y a dix ans, sont en fait bien plus anciennes.

- 1854, La guerre de Crimée : Georges Boole met au point le calcul qu’on appelle aujourd’hui booléen. C’est Claude Shannon qui a redécouvert les travaux de Boole, 83 ans plus tard (1937), et a saisi leur potentiel dans le monde de l’électronique et des télécommunication.C’est ainsi que toute l’informatique moderne, avec ses 0 et ses 1, repose sur les travaux de Georges Boole :

– les puces et leur millions de transistors

– les fichiers multimédia (texte, images, musique, vidéos codés en 0 et 1)

– Internet et ses transferts de paquets

– mais aussi l’intelligence artificielle - 1876, la guerre des Balkans : Melvil Dewey publie la classification décimale qui porte son nom.

- 1910, le début de la révolution mexicaine : Paul Otlet et Henri La Fontaine lancent le Mundaneum, système papier d’indexation de toute la connaissance humaine, qui rassemblera jusqu’à 16 millions de fiches. Une sorte de Google de papier, en somme.

- 1936, le Front Populaire : Alan Turing formalise le principe de l’algorithme, principe sur lequel reposeront tous les langages informatiques futurs.

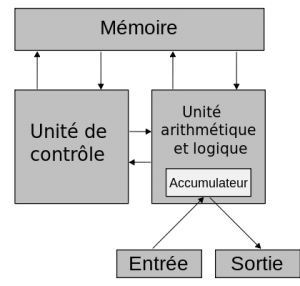

- 1945, l’entrée en vigueur de la Charte des Nations unies : John von Neumann est le rapporteur de travaux pionniers sur un modèle de calculateur à programme (First Draft of a Report on the EDVAC). L’architecture dite de von Neumann est à la base de tous les ordinateurs, tablettes ou smartphones encore aujourd’hui.

1945 est aussi l’année de parution d’un article de Vannevar Bush, As We May Think, qui décrit quelque chose qui ressemble beaucoup à ce qui sera le World Wide Web. Inspiré des travaux de Paul Otlet, Bush y annonce ce que sera la navigation par hypertexte, avec les notions de liens et de parcours.

Le premier ordinateur, l’ENIAC, qui rempli plusieurs étages d’un immeuble de l’armée américaine, est fonctionnel la même année et sera présenté au public l’année suivante, en 1946.

- 1947, partition de l’Inde : À la suite des travaux sur les semi-conducteurs, le transistor a été inventé le 23 décembre 1947 par les Américains John Bardeen, William Shockley et Walter Brattain, chercheurs des Laboratoires Bell. Ces chercheurs ont reçu pour cette invention le prix Nobel de physique en 1956.

- 1956, crise du canal de Suez : John Backus met au point le Fortran, premier langage de programmation de haut niveau, et son compilateur associé. Suivront notamment Lisp (1958), Algol (1958) et Cobol (1959).

- 1959, révolution cubaine : L’année de l’invention du circuit intégré, par Texas Instrument, coïncide avec celle de la première définition du machine learning, par Arthur Samuel. C’est un champ d’études qui donne aux ordinateurs la capacité d’apprendre des tâches pour lesquelles ils ne sont pas spécifiquement programmés. Plus tard, avec l’avènement du Big Data, le machine learning prendra une nouvelle dimension.

- 1965, la minijupe est lancée par André Courrèges (inventée par la styliste anglaise Mary Quant à Carnaby Street la même année) : Ted Nelson formalise la notion d’hypertexte, vous savez, ce truc qui fait qu’on ne lit pas de la même manière sur écran et sur papier : on clique sur un mot et hop! On se retrouve sur une autre page. Sauf qu’en 1965, il ne s’agit pas de cliquer : la souris n’est encore qu’à l’état de schéma.

- 1968, Printemps de Prague : lors de la « Mother of All Demos », sont présentés pour la première fois au public : la métaphore du bureau (desktop), la première souris, l’hypertexte et le courrier électronique. On ne les retrouvera dans un ordinateur du commerce qu’en 1985!

1968 est aussi l’année de la fondation d’Intel, le fabricant de microprocesseurs. - 1969, année érotique : alors que l’homme pose pour la première fois le pied sur la lune, un autre petit pas pour l’homme est la promesse d’un grand pas pour l’humanité : Internet. Le voilà donc, celui dont aucun auteur de sciences fiction n’avait soupçonné l’importance future! Pour l’instant son petit nom est ARPANET et ne concerne que quatre ordinateurs de marques diverses. La première utilisation documentée du terme « Internet » viendra seulement en octobre 1972.

La même année, Kenneth Thompson et Dennis Ritchie commencent à concevoir UNIX, l’ancêtre de tous les systèmes d’exploitation actuels. En parallèle, ils élaborent un langage de programmation qui deviendra le C en 1971, tout simplement le langage le plus utilisé du monde, encore aujourd’hui, et l’ancêtre d’autres langages également très utilisés : C++, Java et PHP.

- 1971, Le Larzac : Le Projet Gutenberg est fondé en juillet 1971 par Michael Hart pour distribuer gratuitement les œuvres littéraires par voie électronique. Le premier eBook est transcrit le 4 juillet 1971. Signe des temps, alors que Gutenberg avait choisi la Bible comme premier livre imprimé, le premier livre électronique est La Déclaration de l’indépendance des États-Unis. Le livre numérique a plus de 40 ans et le Projet Gutenberg est toujours actif !

La même année, nait l’OCLC Online Union Catalog, qui deviendra le plus grand catalogue collectif mondial sous le nom de ‘Worldcat‘ (OCLC = Online Computer Library Center).

C’est enfin l’année où Ray Tomlinson envoya le tout premier message d’un ordinateur relié à un autre par Arpanet. Il est également celui qui a pensé à utiliser un vieux signe du XVIe siècle aujourd’hui connu de tous, l’arobase : @ . - 1973, le premier choc pétrolier : Le projet américain EIES (Electronic Information Exchange System) avait quatre fonctionnalités, où toutes les interventions étaient archivées : les messages électroniques, les conférences électroniques, les bloc-notes électroniques, les bulletins électroniques. C’est donc l’ancêtre à la fois du mail, des forums et des listes de discussions.

1973 est aussi l’année du Xerox Alto, le premier ordinateur à interface graphique porté par la vision d’Alan Kay, reprenant la métaphore du bureau, mais aussi les menus déroulants, les fenêtres et les icônes. Hors de prix, il ne sera pas commercialisé, mais servira de base pour les futurs modèles d’Apple, firme qu’Alan Kay rejoindra en 1984. - 1978, l’Amoco Cadiz : Loi informatique et libertés en France, fondation de la CNIL. La même année, loi CADA sur les données publiques, considérée comme l’ancêtre du mouvement de l’Open Data.

- 1980, le début de la guerre Iran-Irak : Arpanet se divise en deux réseaux distincts, l’un militaire (MILNET, de Military Network, qui deviendra le DDN — Defense Data Network) et l’autre, universitaire (NSFnet), que les militaires abandonnent au monde civil.

- 1981, la victoire de Mitterrand : IBM commercialise le premier PC.

- 1982, le premier bébé éprouvette français, Amandine : Internet adopte officiellement son nom actuel (la première utilisation documentée du terme terme « Internet » remonte à octobre 1972.), et aussi ses principaux protocoles (TCP/IP, FTP, SMTP… mais pas encore HTTP qui n’arrivera que 7 ans plus tard). Internet reste encore cantonné à quelques universités américaines.

Le Minitel est lancé la même année auprès du grand public en France, après une phase de tests utilisateurs à Saint Malo puis sur l’Ille-et-Vilaine. Il transite par le réseau Transpac basé sur le protocole X25. Leurs ancêtres respectifs sont sensiblement de la même époque, puisque ARPANET date de 1969, et X25 de 1971.

Cette année 1982 voit aussi les débuts des technologies tactiles multipoints (université de Toronto et Laboratoires Bell), que le grand public découvrira bien plus tard pour la première fois avec l’iPhone (2007). - 1984, la naissance de Canal + : L’idée du copyleft est lancée par Richard Stallman, ingénieur en informatique et défenseur inlassable du mouvement Open Source au sein de la Free Software Foundation (FSF).

- 1985, Mikhaïl Gorbatchev à la tête de l’URSS : L’ordinateur tel que nous le connaissons est commercialisé. Les icônes, les fenêtres, les clics et la fameuse souris! En un mot ce qu’on appelle l’interface graphique avait été mise au point dans les laboratoires de XEROX (cf ci-dessus, le Xerox Alto en 1973). Avec son Macintosh, Steve Jobs a démocratisé cette innovation avant Bill Gates et son Windows 3.0 (1990). La manière d’interagir avec les premiers ordinateurs, comme l’ENIAC, était de brancher des câbles, puis d’actionner des interrupteurs. Avec l’arrivée des écrans, l’interface homme-machine consistait en lignes de code (UNIX, DOS…). L’interface graphique va démocratiser l’usage de l’informatique.

Le premier micro-ordinateur, le Micral a été créé dès 1973 par un français, François Gernelle. Trop tôt pour le marché. De nombreux projets similaires ont fusé tout au long des années 1970 : Commodore, Tandy, Olivetti, Hewett Packard… Tous livraient leurs machines en kit, ce qui les limitait à un public de bricoleurs en électronique. La vraie nouveauté du Mac, c’est qu’il est livré clé en main, à un prix abordable, et déjà muni de logiciels utiles. L’ADN des produits d’Apple était ainsi déjà présente : ergonomie et intuitivité, une idée piochée chez Atari.

Aujourd’hui, Apple est plus connu pour ses iBook, iPod, iPhone et iPad, mais surtout pour iTunes et l’Apple Store. - 1989, la chute du mur de Berlin : Tim Berners-Lee et ses collègues du CERN dont Robert Cailliau en Suisse mettent au point le World Wide Web. Eh oui! Internet existait sept ans avant le Web, et celui-ci est une invention européenne! Le premier site web est mis en service en 1991, et le 30 avril 1993 marque le passage officiel du World Wide Web dans le domaine public.

- 1991, la dissolution du pacte de Varsovie : Le système d’exploitation Linux du finlandais Linus Torwald est l’anti Microsoft. La philosophie du logiciel libre reprend les fondamentaux de l’Internet des débuts, celui des chercheurs. Chacun contribue à améliorer une solution qui profite à tous, sans que l’argent n’intervienne.

- 1994, la création de l’OMC : Jusqu’alors réservé aux scientifiques, Internet est ouvert au grand public.

Le premier navigateur facilite l’exploration du web. Il s’agit de Mosaic, rapidement rebaptisé Netscape Navigator. Internet Explorer, Mozilla Firefox et Chrome ne viendront que bien plus tard.

Alors qu’au CERN, il était encore facile de parcourir le Web par des arborescences, la production exponentielle de documents sur la toile rend la recherche d’information de moins en moins aisée. Deux étudiants, David Filo et Jerry Yang, mettent au point le premier annuaire : Yahoo! - 1995, découverte de la première exoplanète : Jeff Bezos commence à vendre des livres en ligne sur Amazon, tandis que Brendan Eich créé le premier JavaScript en dix jours à peine, pour le compte de Netscape.

D’autre part le format musical MP3 est lancé par le Fraunhoer-Institut après 10 ans de recherche. Thomson Multimédia, vendu pour un franc symbolique la même année, détient la licence du MP3, car quelques-unes de ses applications ont été utilisées pour la création de ce format. L’industrie musicale se mordra les doigts de ne pas l’avoir pris au sérieux. 20 ans durant, ce format va révolutionner le marché musical. Aujourd’hui, les Majors tirent l’essentiel de leurs revenus du streaming musical, même s’il est beaucoup moins rémunérateur que ne l’était le CD à l’époque (pour les artistes également). Sur ces plateformes, le MP3 et sa qualité dégradée ont souvent laissé la place à d’autres formats. Même si 98 % des jeunes utilisent Youtube pour écouter de la musique, c’est avant une plateforme vidéo, Spotify (2006) utilise l’Ogg Vorbis, Apple Music (2015) l’Advanced Audio Coding (AAC, l’autre nom du MPEG2). Deezer (2007) est l’un des seuls à se montrer fidèle au MP3. Toutefois, Qobuz, Deezer et Tidal proposent désormais des abonnements haut de gamme donnant accès à des fichiers FLAC de bien meilleure qualité, parfois même supérieurs à la qualité CD. - 1997, Titanic de James Cameron : Deepblue d’IBM bat Garry Kasparov aux échecs. Depuis les années 1950, des programmes pour jouer aux dames savaient triompher de joueurs de bon niveau. Il a fallu moins de 30 ans pour qu’ils deviennent meilleurs que les humains aux échecs. 20 ans supplémentaires suffiront pour faire de même avec le jeu de Go.

- 1998, les bleus champions de monde : Larry Page et Sergey Brin fondent Google. Ce n’est pas le premier moteur de recherche, mais il devient rapidement le plus utilisé à travers le monde. Certains jeunes américains ne disent plus « je vais sur Internet », mais « je vais googler ». To google est en effet devenu un verbe. Ainsi en France, certains employeurs « googlisent » leurs futures recrues, pour découvrir ce que leur CV ne montre pas.

En dix ans, la société s’est diversifiée bien au-delà de son métier d’origine : Google Recherche de livres (activité de numérisation de livres de bibliothèques, bientôt associée à une activité d’éditeur-libraire pour les livres plus récents), Google Chrome (navigateur Web), Android (Système d’exploitation pour tablettes et smartphones) et bientôt le Google Store sur le modèle de l’Apple Store.

Par ailleurs, Apple sort l’iMac, l’ordinateur de bureau multicolore qui pour la première fois n’a plus de lecteur de disquettes.

- 2000, l’explosion de la bulle Internet.

- 2001, l’explosion de l’usine AZF à Toulouse : Lancements de Wikipedia et de l’iPod. La nouveauté de ce dernier est qu’il est associé à son magasin de MP3 iTunes. Ce n’est pas le premier lecteur de MP3 : le mpman fabriqué par une entreprise coréenne était sorti en 1998. La production d’iPod s’est arrêtée en 2022. L’essoufflement du marché des lecteurs mp3 est principalement dû à l’essor des smartphones qui, dès 2007 avec l’iPhone, proposaient un lecteur intégré.

- 2004, la mise en service du paquebot Queen Mary 2 : Tim O’Reilly et Dale Dougherty fondent l’expression Web 2.0. Mark Zuckerberg lance Facebook, qui concurrencera bientôt Google en fréquentation.

- 2005, l’ouragan Katrina en Louisiane : Michael Casey défini ce qu’est une Bibliothèque 2.0. Création de Youtube, qui sera racheté l’année suivante par Google.

- 2007, la mort de l’abbé Pierre :

- Les opacs de nouvelle génération arrivent sur le marché.

- Fondation de la société Twitter, Inc.,

- Début des négociations sur le traité ACTA

- Lancements du Kindle par Amazon (liseuse portable) et de l’iPhone par Apple (interface tactile multipoint qui sera reprise deux ans plus tard sur l’iPad). A noter que le « pincer pour zoomer » a été mis au point par la firme japonaise Mitsubishi dès 2001.

Les racines de l’informatique contemporaine sont semées : importance grandissante des réseaux sociaux, guerre des tablettes pour écouler du contenu propriétaire, essor du Web applicatif et risque de cloisonnement d’Internet. Nous sommes à la veille d’un nouveau changement de paradigme auquel personne n’a encore donné de nom.

- 2011, La dernière navette spatiale américaine est retirée du service : Dans iPhone 4s, le « S » signifie Siri. Cette application issue de l’intelligence artificielle comprend les instructions verbales données par les utilisateurs et répond à leurs requêtes. Google et Microsoft suivront le mouvement, ainsi que plusieurs constructeurs (Samsung, LG…). Google Now sort en 2012 et Cortana en 2014

- 2012, JO de Londres : Fin du service Minitel en France.

- 2013, Xi Jinping président de la Chine : Edward Snowden révèle le programme d’espionnage et de surveillance à grande échelle de la NSA

- 2014, référendum sur l’indépendance de l’Écosse : Le groupe chinois Alibaba entre à la bourse de New-York, réalisant la plus grosse introduction Hight-Tech en bourse de l’histoire (devant Google et Facebook).

- 2015, Attentat à Charlie Hebdo : Les violences des taxis envers les VTC font entrer un nouveau terme dans le vocabulaire médiatique : « uberisation de la société« . Le numérique déborde des écrans du fait du parasitage de l’économie collaborative (exemple, les plateformes de crowdfunding) par le capitalisme le plus libéral. Des indépendants – précaires – travaillent en versant une commission à une plateforme, laquelle offre un service, accessible via une application de smartphone (cf 2007), qui devient intéressant par le nombre même de ces indépendants. A la différence des géants de l’économie d’antan, Uber ne compte pas des dizaine ou des centaines de milliers d’employés, mais il organise cependant leur travail. Par extension, le terme recouvre toutes les intermédiations occasionnant un détournement de la valeur. Blablacar ou Uberpop représentent le transport, AirBnb ou Booking le tourisme, Amazon l’édition, La Ruche qui dit oui l’agriculture, etc. Mais de nombreux autres secteurs vont y passer.

- 2017, Trump président des USA : Nourri par des millions de parties humaines, AlphaGo de Google bat au jeu de go Lee Sedol en 2016 et Ke Jie en 2017. Si une autre machine, l’ordinateur Deep Blue d’IBM, avait déjà triomphé du champion du monde d’échecs Garry Kasparov en 1997, le défi du jeu de go apparaissait comme plus compliqué pour l’intelligence artificielle. En effet, il existe plus de configurations possibles dans le jeu de go que d’atomes dans l’univers. De plus, la discipline fait appel à des concepts stratégiques et requiert intuition et créativité, des qualités qu’on pouvait estimer supérieures chez l’homme.

Successeur d’AlphaGo, AlphaZero en décembre 2017 surpasse largement le niveau de tous les joueurs humains et logiciels, non seulement au jeu de Go, mais aussi aux échecs et au Shōgi. Sa logique est différente car elle repose sur l’auto-apprentissage : son programme ne contenait à l’origine que les règles du jeu. Il a appris tout seul en jouant des millions de parties contre lui-même. - 2018, les bleus champions de monde (bis) : Facebook est éclaboussé par le Scandale Cambridge Analytica. Apple devient la première entreprise privée à valoir plus de 1 000 milliards de dollars en bourse. Amazon passe le même cap peu de temps après.

- 2021, Virgin Galactic (Richard Branson), Blue Origin (Jeff Bezos,) et SpaceX (Elon Musk) inaugurent le tourisme spatial privé : Open AI lance GitHub Copilot, un assistant basé sur l’intelligence artificielle pour les développeurs informatiques. Basé sur le code déposé sur GitHub la plateforme rachetée par Microsoft, Copilot est critiqué par le monde du libre sur la question du droit d’auteur, puisque le code déposé sur GitHub est libre, alors que Copilot est payant

- 2023, L’Inde devient le pays le plus peuplé du monde, devant la Chine : Open AI lance chat GPT 3, une IA conversationnelle tous domaines. Deepblue ne jouait qu’aux échecs, Alpha Go qu’au jeu de Go, Copilot ne générait que du code, Midjourney ou DALL-E que des images. Conçue pour imiter la conversation humaine et pourvu qu’on lui fournisse un contexte pertinent, chat GPT 3 est capable générer tous types de textes, de la recette de cuisine à la poésie en passant par la traduction automatique ou le code informatique. Parmi les nombreux domaines impactés, on trouve les moteurs de recherche. Microsoft décide d’intégrer chat GPT 3 dans son moteur Bing. En réaction, Google dévoile tous les projets d’IA qu’il avait dans ses cartons et annonce la sortie d’une vingtaine de nouveautés dans l’année. Il s’agit en particulier de l’agent conversationnel Bard, de la recherche multicritère (images + texte), des vues immersives avec réalité augmentée sur Maps, d’une traduction améliorée, etc.

Depuis plusieurs année maintenant, la plupart des gens ont opté sobrement pour l’acronyme TIC, mais il y a encore des irréductibles pour utiliser NTIC. Je me rappelle qu’en 1999, le sens de l’Histoire, c’étaient les portails et le KM (Knowledge Management ou gestion des connaissances). Tous deux ont depuis retrouvé la confidentialité. En 2010, la nouvelle coqueluche des médias était le 2.0. Tout ce qui était nouveau était 2.0. C’était la mode du moment, comme les NTIC, les portails et le KM en leur temps. Et comme ses aînés, le 2.0 commençait à dater alors même que le buzz était au plus fort : six ans d’âge. Mais le thème était porteur : Web 2.0, Bibliothèques 2.0, Catalogue 2.0, etc… jusqu’au jour où d’autre expressions prendront le relais. Par exemple, entre les attentats de Charlie/hyper casher en 2015 et l’élection de Donald Trump en 2017, les médias ont beaucoup parlé des fake news et du conspirationnisme, dont les réseaux sociaux seraient les vecteurs. Le numérique a quitté la sphère strictement technique et irrigue aujourd’hui toute la société, d’où la diversification des thèmes qui y sont associés.

Mais à bien y réfléchir, est-ce que les profils qui sont à la base des réseaux sociaux -Facebook, Instagram, Youtube et consorts- est-ce que ces profils ne descendraient pas en ligne directe des préconisations liées au concept de portail? C’est à dire une personnalisation de l’interface poussée jusqu’au niveau individuel? De même, une autre caractéristique du Web 2.0, le crowdsourcing, ne descendrait-elle pas au moins en partie du KM avec ses outils collaboratifs? Le phénomène est plus profond qu’une simple question de marketing. Fascinante science que l’histoire, où il est toujours difficile de démêler l’œuf et la poule. Au temps où KM et portails étaient à la mode, on imaginait des développements qui n’ont jamais eu lieu, mais dans les applications qui ont suivi, on reconnaît à posteriori la filiation avec les technologies qui ont précédé.

[Dernière mise à jour le 12/10/2020]

Lisez aussi :

<MAJ du 18 juillet 2016 : Pour une histoire de l’informatique>

Si les ordinateurs et outils numériques sont partout ou presque aujourd’hui, l’humanité n’est pas née avec une souris dans la main. D’Alan Turing à Steve Jobs en passant par Claude Shannon, du premier « personal computer » à l’invention du web, quelles sont les grandes étapes et les acteurs de cette histoire qui relève à la fois de l’histoire technique, scientifique, industrielle et culturelle ?

Les Passeurs de science – France Culture, 10-07-2016

- L’informatique… toute une histoire ! – The Conversation, 21 août 2017

- La naissance du numérique – The Conversation, 16 juillet 2018

- Histoire d’Internet – Wikipedia

</maj>

<MAJ du 20 septembre 2017 : L’histoire s’écrit toujours à la lumière du présent>

J’ai fait l’impasse sur bien des étapes dans ma petite histoire du numérique, car elles n’ont plus beaucoup de pertinence aujourd’hui :

</maj>

<MAJ du 21 septembre 2017 : Et les jeux vidéo, ce ne sont pas des « NTIC »?>

J’ai également laissé de côté l’histoire du jeu vidéo, qui s’est déroulée en parallèle de celle de l’informatique, depuis le premier jeu animé (Tennis for Two, sur un oscilloscope en guise d’écran en 1958, dont le paddle constitue aussi le premier joystick de l’histoire), aux jeux sur smartphones actuels, en passant par :

- les bornes d’arcade (Computer Space, 1971),

- les consoles de salon (Odyssey, 1972),

- les ordinateurs (Amiga, Atari ST, 1985)

- et les consoles portables multi-jeux (Game Boy, 1989)

qui n’ont cessé d’évoluer jusqu’à aujourd’hui, avec des versions en ligne -LAN party ou Internet- (jeu Ultima Online sur PC, 1997 ; console Xbox, 2001).

Il faudrait aussi détailler les jeux et les marques qui ont laissé leur empreinte dans l’industrie du jeu vidéo. Je vous renvoie vers Wikipédia pour en savoir plus :

- Pong

- Histoire du jeu vidéo

- Jeu de rôle en ligne massivement multijoueur (MMORPG)

- Jeu en ligne massivement multijoueur (MMOG)

- Sport électronique

Sur France Culture, Jean Zeid, spécialiste des jeux vidéo et chroniqueur à France Info donne un état des lieux de ce qu’est le jeu vidéo aujourd’hui. Il nous propose également une histoire générale des jeux vidéo de Pong à Tomb Raider, d’Homère à Nietzsche.

Les chemins de la philosophie – France Culture, 18/09/2017 (58 min)

</maj>

<MAJ du 07 mai 2014 : Une histoire des (nouvelles) TIC qui remonte au XIXe siècle!>

« Les historiens retracent habituellement les origines du world wide web à travers une lignée d’inventeurs Anglo-Américains tels Vannevar Bush, Doug Engelbart et Ted Nelson. Mais plus d’un demi siècle avant que Tim Berners Lee ne développe le premier browser web en 1991, Otlet décrivait un monde en réseau où « quiconque, depuis son fauteuil, pourrait contempler la Création… »

Alex Wright (New-York Times)

Paul Otlet, Henri La Fontaine, Melvil Dewey, des noms bien connus des documentalistes, mais inconnus des informaticiens comme du grand public. Le Mundaneum ira jusqu’à rassembler 16 millions de fiches, véritable moteur de recherche de papier, un siècle avant Google!

Paul Otlet, le belge qui a rêvé Internet

La vie Numérique – France Culture, 10/01/2017 (4 min)

</maj>

Retour de ping : InfoDocBib – Le blog » Blog Archive » Retour d’expérience exotique

Retour de ping : InfoDocBib – Le blog » Blog Archive » Laptops, laptops everywhere (1)

Retour de ping : InfoDocBib – Le blog » Blog Archive » « Nouveaux usages » et management

Retour de ping : InfoDocBib – Le blog » Blog Archive » Les « nouveaux » catalogues

Retour de ping : Téléphone fixe : la fin du RTC et le passage au tout IP Infodocbib.net

Retour de ping : Algorithmique et algorithmes | InfoDocBib - Architecte de l'information

Retour de ping : Python, une initiation InfoDocBib - Architecte de l'information

Retour de ping : Quel langage informatique apprendre en 2020 ? Architecte de l'information

Retour de ping : Frameworks JavaScript | InfoDocBib - Architecte de l'information

Retour de ping : 30 ans de développement web - Infodocbib.net

Retour de ping : IA génératives : coder sans développeurs ? - InfoDocBib - Architecte de l'information

Retour de ping : Windows 11, un gigantesque spyware

Retour de ping : End of 10 : l'occasion de passer à Linux ? - InfoDocBib - Architecte de l'information

Retour de ping : Laragon, mon nouvel outil PHP/SQL - InfoDocBib - Architecte de l'information